Pour les principales agences étudiant le climat de la planète, l’année 2014 a été la plus chaude depuis le début des relevés. Si les résultats convergent, ces institutions annoncent des moyennes de températures légèrement différentes. La NASA vient de publier une brève explication qui permet de mieux comprendre comment les moyennes globales sont obtenues. Selon certains chercheurs, les méthodes retenues pourraient même expliquer pourquoi le réchauffement a semblé ralentir depuis 1998.

Les scientifiques utilisent 3 grandes bases de données pour étudier la température globale : Gistemp (NASA), NOAA, et HadCRUT4 (Met Office – Université d’East Anglia). Il y aussi la Japan Meteorological Agency (JMA), moins connue, mais qui a le mérite de publier ses données un peu plus rapidement.

La température moyenne de la planète est calculée par ces quatre instituts en combinant les mesures des stations météo au sol et celles à la surface des océans (grâce aux bateaux, aux bouées et parfois aux satellites).

Bien que les quatre institutions scientifiques aient de fortes similitudes dans la façon dont elles collectent et analysent des températures, il y a des différences subtiles. C’est ce que vient de rappeler la NASA dans une récente note. Ces différences tiennent principalement à la collecte des données et aux éventuelles méthodes utilisées pour calculer les températures dans les zones non couvertes. Les agences diffèrent aussi dans la période de référence retenue pour calculer les anomalies de températures mais c’est plus anecdotique.

Si les stations sont nombreuses à la surface des terres, il y a cependant des trous dans la collecte des données pour les océans, les régions polaires et même des zones d’Afrique et d’Amérique du Sud.

Les quatre agences principales abordent ces problèmes de façon différente. La JMA ne couvre que 85% du globe, laissant les régions manquant de stations météo en dehors de ses analyses. Le Met Office (HadCRUT4) a fait un choix similaire et ne couvre que 86% de la planète avec 5500 stations. La NOAA utilise une autre méthode, l’interpolation des températures dans les zones qui manquent de données. L’interpolation est un outil statistique permettant de calculer des données manquantes grâce aux stations les plus proches. Grâce à cette méthode, la NOAA affiche une couverture de 93% avec 7000 stations. La NASA va encore plus loin et se montre plus « agressive », selon ses propres termes. La NASA utilise l’interpolation pour des zones non couvertes jusqu’à 1200 km des stations les plus proches, ce qui lui permet de couvrir 99% de la planète avec 6300 stations. En outre, la NASA est aussi celle qui affiche le maillage le plus fin et le plus précis.

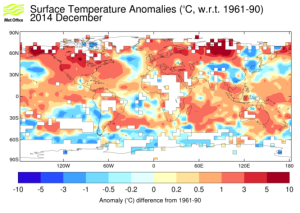

Exemple de la surface couverte par Gistemp : anomalies de températures pour le mois de décembre 2014 (Source : NASA)

La principale différence entre les données de températures est donc la manière avec laquelle les scientifiques abordent les régions les plus reculées. HadCRUT4, on l’a vu, préfère laisser en dehors de sa moyenne globale les régions où les données de terrain son manquantes même si des progrès ont été faits dans la couverture globale. La NOAA et la NASA essayent de couvrir davantage de territoire. Toute la question est de savoir comment ces choix influent sur les moyennes globales qui sont délivrées au final.

Exemple de la surface couverte par HaCRUT4 : anomalies de températures pour décembre 2014 (Source : Met Office)

Cela ne poserait pas de problème si le réchauffement climatique était uniforme. Mais il ne l’est pas : l’Arctique, par exemple, se réchauffe à un rythme deux fois plus rapide que le reste du globe. Un jeu de données qui tiendrait cette région à l’écart manquerait donc une part importante du réchauffement.

En plus des agences qui collectent les données des stations au sol, des mesures sont effectuées par satellite. Même si la tendance de long terme est similaire à ce qu’obtiennent la NASA, la NOAA, le Met Office et la JMA, les données des satellites divergent sur la question des records de températures, plaçant 1998 au sommet.

Kevin Cowtan, de l’Université de York, et Robert G. Way, de l’Université d’Ottawa, ont publié en 2013 une étude de référence sur l’impact des méthodes utilisées pour reconstituer la température globale de la planète. Pour les deux chercheurs, les trous dans la couverture météo sont une source d’erreur. Cowtan et Way ont étudié l’incidence des données manquantes de HarCRUT4, notamment aux pôles et en Afrique.

Cowtan et Way pensent pouvoir déterminer pourquoi les années 1998 et 2010 ont été marquées par des records. L’influence d’El Niño est connue depuis longtemps mais les deux scientifiques ont pu préciser comment les caractéristiques climatiques de ces années record s’étaient traduites dans les relevés de températures du Met Office.

Bien que 1998 et 2010 aient été toutes deux marquées par des événements El Niño, le phénomène a été beaucoup plus fort en 1998. En revanche, 2010 a été marquée par une oscillation arctique négative très prononcée (avec les valeurs les plus importantes des 50 dernières années). L’oscillation arctique négative permet à l’air froid des pôles de descendre plus au sud. Il fait donc plus chaud en Arctique que lors d’une oscillation positive qui conserve l’air polaire dans les hautes latitudes. 1998 a donc connu un fort réchauffement tropical alors que 2010 a été marqué par des températures arctiques plus élevées qu’à l’accoutumée. Le fait que les basses latitudes soient mieux couvertes par les stations météo que les régions polaires a donc créé un biais dans le jeu de données du Met Office.

Une correction devrait donc être appliquée pour reconstituer fidèlement la température moyenne de la planète et dans ce cas les températures de 2010 seraient réévaluées par rapport à 1998. Une donnée à prendre en compte quand on sait que certains affirment que depuis 1998 le réchauffement climatique plafonne.

Quoi qu’il en soit, les différentes agences obtiennent des résultats similaires pour la tendance du réchauffement sur la période 1980-2014, comme on peut le voir ci-dessous.

Met Office (HadCRUT4) : +0,16°C par décennie sur 1980-2014

NASA (Gistemp) : +0,156°C par décennie

NOAA :+0,148°C par décennie

UAH (Satellite) : +0,141°C par décennie

RSS (Satellite) : +0,126°C par décennie

Les années 90 se sont distinguées par des épisodes El Niño récurrents, avec un épisode exceptionnel en 1998. Les stations au sol et les satellites ont bien répercuté dans leurs données le réchauffement dû à ce phénomène, vu qu’il affectant surtout les basses latitudes. En revanche, si le réchauffement a été plus marqué dans les régions polaires dans les années 2000, on peut soupçonner qu’une mauvaise couverture de ces zones ait pu donner l’impression d’une pause dans le réchauffement climatique.

Catégories :Climat

« si le réchauffement a été plus marqué dans les régions polaires dans les années 2000, on peut soupçonner qu’une mauvaise couverture de ces zones ait pu donner l’impression d’une pause dans le réchauffement climatique. » : … et le refroidissement actuel des pôles (voir l’augmentation de la banquise arctique et les records de la banquise antarctique) donne l’impression que la terre s’est réchauffée en 2014, non ?

J’aimeJ’aime

Les températures des pôles sont plus difficiles à établir en raison du manque de données. Certaines études parlent d’un réchauffement 8 fois plus rapide en Arctique (Cowtan & Way) que la moyenne et on observe que les agences qui couvrent moins bien cette région ont relevé un réchauffement moins important au niveau global. Pour la période récente, on ne peut pas vraiment parler d’un refroidissement de l’Arctique en 2014 car on a quand même eu la 6è plus faible extension en septembre. En janvier 2015, alors que la glace de mer est censée atteindre son plus haut niveau au pôle nord, on n’a enregistré que la 3è plus faible extension depuis le début des relevés… Quand à l’Antarctique, son isolement le rend un peu spécial. Si les glaciers de l’Antarctique de l’ouest fondent à un rythme soutenu, on a effectivement observé ces dernières années une extension record de la glace de mer. La glace de mer peut varier de manière importante en Antarctique en raison des vents puissants qui entourent et isolent ce continent. Ce courant s’est d’ailleurs déplacé vers le sud ces dernières années… Notez que l’Australie en subit les conséquences avec des canicules.

J’aimeJ’aime